皆さんのサイトは、XMLサイトマップ(sitemap.xml)とロボッツテキスト(robots.txt)をきちんと設定していますか?

どちらも直接検索順位に影響するものではありませんが、検索エンジンに効率よくサイトをクロールしてもらうために必要なものです。

「え?なにそれ?」と思った方はもちろん、「設定してるけど、これでいいのかな…?」と心配に感じている方も、ぜひこの記事を読んで参考にしていただければ幸いです。

目次

「うちのサイトにはあるのかないのかわからないなあ…」という場合、ご自身のサイトの末尾に下記のように入力し、そもそも設置がされているのか確認してみましょう。

robots.txt

http://www.example.com/robots.txt

何やら機械的な文字がズラズラと出てきた場合、設定されています。

「404エラー」などと出てきた場合は、そもそも設定自体がされていない可能性があります。

検索エンジンは、クローラーと呼ばれるロボットにサイトを巡回(クロール)させ、サイトの情報を取得しています。

robots.txtは、主に検索エンジンの巡回を指示するファイルです。クローラーは、robotst.txtを一番最初に読み込んで、クロールすべきページとクロールすべきでないページを確認し、効率的にサイトを見ています。

主な用途は以下のふたつです。

テキストエディタを開き、以下のように記述することで機能します。

ファイル名はrobots.txtと記述して、第一階層(TOPページのファイルが置いてある場所)にアップロードしてください。

「User-agent: *」は「あらゆるユーザーエージェントのロボットに対して命令する」という意味です。

PC用Googleのクローラーにのみ命令したければ「User-agent: Googlebot」、画像収集用Googleのクローラーにのみ命令したければ「User-agent: Googlebot-Image」、モバイル用Googleのクローラーにのみ命令したければ「User-agent: Googlebot-Mobile」となります。

「Disallow:」は「拒否する」という意味で、ここに「/」から始まるクロール拒否したいURLを記述します。この内容は部分一致で認識されますので、上記の例の場合、「/abc/」以下すべて、つまり「/abc/」も「/abc/efg/」も「/abc/efg.html」も全てクロールされなくなります。

会員専用ページなどに対して使用することになるでしょう。このサイトでもサンクスページのURLがインデックスされることの無いよう、robots.txtを設定しています。

部分一致で認識されますので、ディレクトリごと拒否したい場合はきちんと末尾の「/」まで記述するように注意してください。例えば「/abc」と記述しただけでは「/abc/」に加えて「/abcefg/」もクロールされなくなってしまいます。

「Disallow:」と反対の意味で「Allow:」(許可する)というコマンドもありますが、あまり使用することはありません。

もしすでにインデックスされているURLを削除したいときは、先にを指定するなどしてインデックスが無くなったことを確認してからrobots.txtを使用する方が確実でしょう。

robots.txtによる「Disallow」の役割はあくまでクロールの拒否であってインデックスの削除では無いからです。

robots.txtに以下のように記述することで、検索エンジンにsitemap.xmlの場所を通知することが可能です。

「http://www.example.com/sitemap.xml」部分は任意のURLに書き換えてください。

sitemap.xmlは複数指定することもできます。また、Googleはこのsitemap.xmlの設置場所について非常に寛容で、外部ドメインを指定することもできます。

特に意味はないのであまりお勧めはしませんが、Google自身が外部ドメインのsitemap.xmlを指定しています。

なお、上記に加えてウェブマスターツールでsitemap.xmlを送信しておくとより確実です。

余談ですが、robots.txtの記述を間違うと、インデックスが削除されてしまうこともありますので、最新の注意を払いながら作業にあたりましょう。

XMLサイトマップとは、検索エンジンにサイト内のURLや動画の情報を告知するためのファイルです。

Google等のロボット型検索エンジンがサイトをクロール(巡回)しにきたときに、そのサイトの構造を効率的に知らせることができます。

設置したからといって上位表示に直結するわけではありませんが、クローリングが効率的になるということは、結果的にSEO上好ましい状態に近づくということになるでしょう。

では、ファイルの適切な記述方法をご紹介します。

参考:Search Console ヘルプ サイトマップについて

WEBサイトに動画をアップしている場合には、専用の書式のサイトマップを使って検索エンジンに伝えることができます。

今後ユニバーサル検索やバーティカル検索がさらに進化して検索結果画面に動画が出現するシーンが増えていくことが予想されますので、こうした方法は積極的に活用してインデックスコントロールをしていきましょう。

<urlset>が通常のXMLサイトマップと異なりますので、ファイル名を「sitemap-video.xml」等として設置するとよいでしょう。

動画サイトマップには非常に豊富なオプションが用意されていますので、Googleの公式アナウンスを参考に出来る限り周辺情報を盛りこんでいきましょう。

検索エンジンも動画の内容解析を進化させるべく努力はしているようですが、まだまだ技術的には不足が目立ちます。動画サイトマップに周辺情報を記載することで、動画そのものとそれが掲載されているページのテーマを的確に伝えることができます。

これまでご紹介した方法は、基本的に自分で記述・更新を行う必要があります。

ほとんど更新のないコーポレートサイトや、ページ数の少ない静的サイトなら大した労力は要しませんが、新規ページがバンバン追加されたり、ページ数が非常に多いサイトでSitemap.xmlを更新したり、追加したりというのは非常に手間がかかります。

しかし、プラグインを使用すれば、ワンクリックでページ抜けすることなく、sitemap.xmlの作成が可能です。新規ページが追加された場合でもプラグインが自動でsitemap.xmlを更新してくれるので更新の手間もありません。

「sitemap.xmlを作れるプラグイン」と一言で言っても、何種類ものプラグインが存在します。

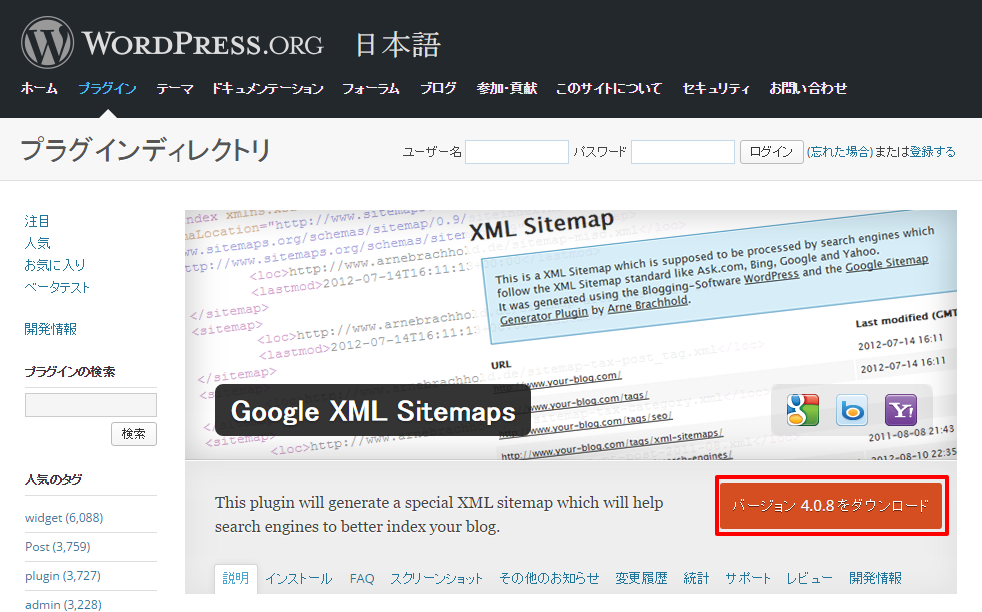

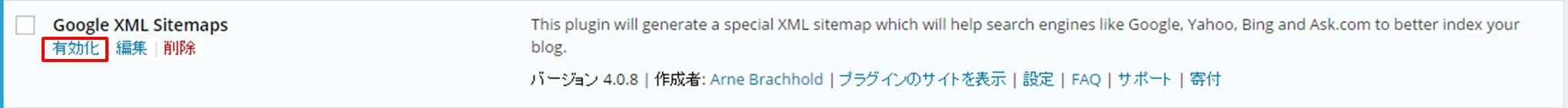

Google XML Sitemapsは、その中でも最も有名なもののひとつです。

利用方法も非常に簡単です。まずはプラグインをインストールします。

そして、有効化ボタンを押すだけ。

ただし、有効化した時点ではまだsitemap.xmlは生成されていません。記事を投稿すると、sitemap.xmlが自動生成されるようになります。

あとは記事を更新するだけで、プラグインが自動でsitemap.xmlを更新してます。

ちなみに、「Google XML Sitemap」という紛らわしいプラグインがあるので注意が必要です。

”Sitemap”の最後に”s”が付くか付かないかの違いです。正しいのは”s”付ですので、インストールする際は気をつけてください。

初期設定状態では、「ホーム」「投稿ページ」「固定ページ」の3つに属するURLのみsimap.xmlに記載する設定となっています。よって、カテゴリーやタグによって生成されされるアーカイブのURLなどは含まれていません。

あえてこれらをSitemap.xmlに記載する必要もないとは思いますが、記載しなければいけない理由がある場合でも対応可能です。

Sitemap.xmlには更新頻度(changefreq)と優先順位(priority)を記載できるのですが、その設定もこのプラグインで細かくすることができます。基本的に的にこちらもデフォルトの設定で問題ないと思いますが、本当に細かく設定したい場合は調整することが可能です。

ひとつのsitemap.xmlには5万URLまでしか記述できません。また、ファイル容量が10MBを超えてもなりません。

また、モバイル用ページをサブディレクトリで展開している場合など、ひとつのサイトに二つ以上のsitemap.xmlを設置したい場合はあると思います。そういった場合には2通りの方法が考えられます。

サイトマップインデックスファイルとは、複数のXMLサイトマップの場所を記述した目次ファイルのことです。以下は「/m/」以下でモバイル用ページを展開し、第一階層にPC用のsitemap.xml、「/m/」直下にモバイル用のsitemap.xmlを設置した例です。

<sitemapindex xmlns=”http://www.sitemaps.org/schemas/sitemap/0.9″>

<sitemap>

<loc>http://www.example.com/sitemap.xml</loc>

</sitemap>

<sitemap>

<loc>http://www.example.com/m/sitemap.xml</loc>

</sitemap>

</sitemapindex>

サイトマップインデックスファイルのファイル名は「sitemap_index.xml」としておきましょう。ちなみにこの場合、robots.txtには以下のように記述します。

Sitemap: http://www.example.com/sitemap_index.xml

robots.txtには複数の「Sitemap:」を指定することができます。一つ目の方法より手軽なやり方です。

Sitemap: http://www.example.com/sitemap.xml

Sitemap: http://www.example.com/m/sitemap.xml

いずれの場合でも「Googleウェブマスターツール」を通じて検索エンジンにXMLサイトマップの場所を通知しておくとよいでしょう。

世の中には便利なサイトマップジェネレータがいくつか存在します。以下は私がよく活用させていただいているものです。

参考:サイトマップを作成-自動生成ツール「sitemap.xml Editor」

ただし注意点もあります。

さて、ここまでXMLサイトマップ(sitemap.xml)とロボッツテキスト(robots.txt)の記述方法をご紹介してきましたが、いかがでしたか?

ロボット(検索エンジン)との意思疎通にはとても手間がかかりますが、サイトのことを良く知ってもらうためには必要な作業ですので、皆さまもぜひ、この記事を参考に設定してみてください。

ディーエムソリューションズのSEOコンサルタント、犬塚と申します。 過去には、「SEOコンサルタントがこっそり教えるSEO施策のコツ」など、…

私たちがSEO事業をスタートした2006年のSEO施策は、現在の施策とは大きく異なるものでした。 人工的な外部リンクが隆盛を極め、とにかくリ…

皆さんはSEOを外注ではなく、自分で実施したいと考えたことはありませんか? 外部リンクによるSEOが終焉に近づき、コンテンツによるSEOが全…

SEOを考える上で検索エンジンのことを知ることは非常に重要なポイントです。 なぜなら、SEO(Search Engine Optimizat…

「デザインを変えたい」「更新をもっと楽にしたい」などホームページをリニューアルする理由は様々だと思いますが、折角リニューアルしたからには今ま…

アンカーテキストとは、HTMLファイルに記述するアンカータグ(<a>~</a>)で囲まれたテキストのことで、リンクテ…

今話題のAIによるコンテンツ自動生成機能も!SEO対策に本当に必要な機能だけを搭載した使いやすさとコストパフォーマンスに優れたWeb集客支援ツールです。

Webマーケティングに関わる施策全般をワンストップで

ご提供します。

お気軽にご相談ください。

Webマーケティング最新ニュースのレポートや無料セミナーの先行案内が届く、お得なメルマガ配信中!