Search Consoleのインデックスカバレッジレポートで「送信されたURLがrobots.txtによってブロックされました」とエラーが出てしまい困っていませんか? ここでは、エラーの原因と内容を解説し、対処方法を詳しく解説します。

それでは「送信されたURLがrobots.txtによってブロックされました」のエラー内容について、確認していきましょう。

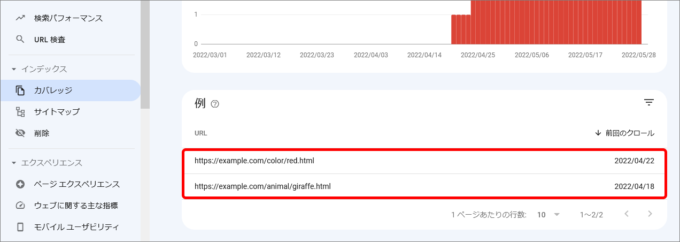

Search Consoleでは、[インデックス] > [カバレッジ]から下記の画像のように表示されていると思います。

このエラー内容について、GoogleのSearch Consoleヘルプでは、下記のように記載されています。

送信された URL が robots.txt によってブロックされました: インデックスに登録するために送信したページが、robots.txt によってブロックされています。

(引用)Search Console ヘルプ. 「インデックス カバレッジ レポート」

これだけでは分かりづらいので、以下でエラー内容を説明します。

このエラーを理解するには、言葉を分解して理解に努めるとよいでしょう。

まず「送信されたURL」とは、Search ConsoleでURLを直接送信、もしくはxmlサイトマップに記載されたURLを指します。これらは、URLの存在をGoogleに知らせることでクロールを促す意味合いがあります。そして「robots.txt によってブロック」は、クロールを許可もしくは不許可の制御が可能なrobots.txtファイルの中に、クロールを不許可する記述があることを示します。

分解した意味をつなげると「xmlサイトマップに記載されているURL一覧に、robots.txtファイルでクローラによるクロールが禁止されているディレクトリまたはページがあります」という意味になります。

つまり、Googleにインデックス登録を依頼したにもかかわらず、robots.txtでディレクトリまたはページをクロールしないように設定されていて、クローラがページの内容を読み取ることができないときに表示されるエラーです。

なぜ「送信されたURLがrobots.txtによってブロックされました」のエラーが出るのでしょうか?

様々な原因が考えられますが、代表的な原因は下記が挙げられます。

原因を突き止める方法と解決方法を次に説明します。

「送信されたURLがrobots.txtによってブロックされました」のエラーを解決する方法を説明していきます。このエラーの原因を突き止めるうえで理解が必要なrobots.txtは、詳細にまとめたページもご参考にしてください。

⇒デジ研「robots.txt(ロボッツテキスト)とは? 正しい記述方法を徹底解説」

まずはエラーの問題が発生しているURLを確認しましょう。

まずは、問題が発生しているURLを確認しましょう。

Search Consoleの[インデックス] > [カバレッジ]の順に表示すると下記のようにカバレッジの詳細が表示されます。

「送信されたURLがrobots.txtによってブロックされました」のエラー項目をクリックすると該当するURLが表示されます。

こうして該当するエラーのURLを抽出した上で、対応方針を決めていきます。

エラーとなったURLは、意図的にブロックしているのか、意図せずCMSなどの設定でブロックされてしまったのかによって必要な対応が異なります。

テストページの作成などで、まだクロールされたくないディレクトリまたはページを意図的にブロックし、設定を消し忘れていた場合、robots.txtの設定でブロックしているディレクトリまたはページを削除してください。

引き続きクロールされたくないディレクトリまたはページであれば、サイトマップから該当のURLを削除し、robots.txtのブロックの設定は、そのままにしてください。

意図せずCMSなどの設定で、クロールしてほしいディレクトリまたはページにブロックの設定がされてしまうこともあります。その場合、CMSの設定で該当URLをブロックしないよう設定してください。

それでは、問題の起きているURLを修正していきましょう。ここでは、CMS(Wordpress)の設定とrobots.txtの記載、xmlサイトマップの修正方法を紹介します。

CMSの設定でクローラによるクロールをブロックする設定になっている。気がつかないうちにこの設定を変更してしまっていないか確認しましょう。

WordPressの場合

[設定] > [表示設定] > [検索エンジンでの表示設定] から設定にチェックが入っていないことを確認しましょう。

ここにチェックを入れると、クロールをブロックする設定になります。

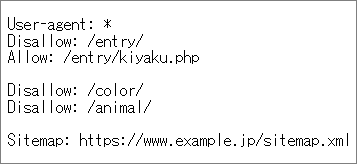

まずは、robots.txtの中身を確認しましょう。

下記のようなURLをブラウザに直接打ち込んでみてください。

https://(サイトのURL)/robots.txt

robots.txtが設置されている場合、サイトによってさまざまですが、下記のような文字が表示されます。

ここで確認していただきたいのは、Disallow(禁止)の設定です。

ここにSearch Consoleで問題が発生しているURLが記載されていないか、確認してください。

記載されていて、そのURLをクローラにクロールしてほしい場合は、そのURLのDisallowの記述を削除してください。

引き続きクロールしてほしくない場合は、記述は削除しないでください。

サイトマップにSearch Consoleで問題が発生しているURLが記載されていないか、確認してください。

サイトマップには、robots.txtでクロールをブロックしているURLを記載してはいけません。

記載されている場合は、サイトマップから該当URLを削除してください。

「送信されたURLがrobots.txtによってブロックされました」のエラーは、ほとんどのケースでrobots.txtでブロックしているURLが、なんらかのきっかけでサイトマップに記載されてしまっていることが原因として考えられます。

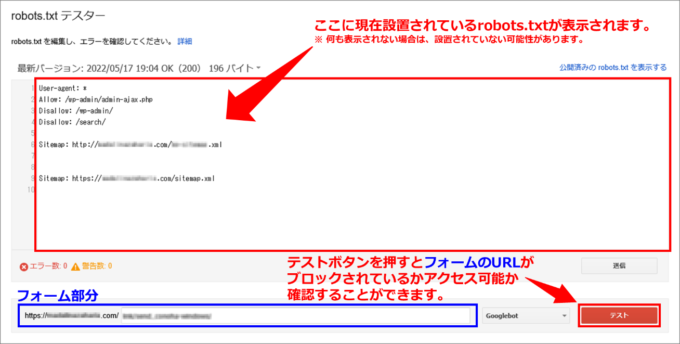

修正した後は、正しく反映されているかをrobots.txtテスターでチェックします。robots.txtテスターでは該当URLに対してクローラがブロックされているかどうかを確認できます。

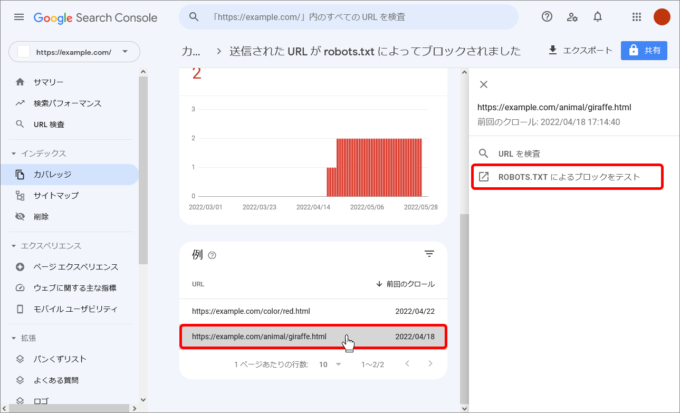

エラーとして表示されているURLをクリックすると、ツールのサイドパネルが展開されます。

[ROBOTS.TXTによるブロックをテスト]をクリックすると、robots.txtテスターが実行され、そのURLがブロックされているか確認することができます。

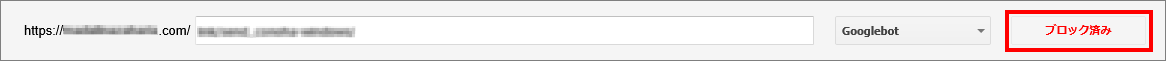

クローラがクロールできない状態の場合、「テスト」ボタンが「ブロック済み」というメッセージになります。

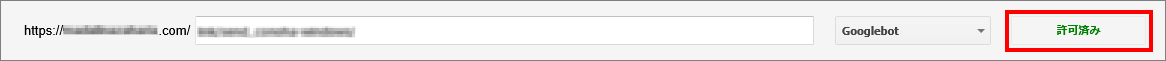

クローラがアクセスできる場合は、「許可済み」というメッセージが表示されます。

ここでは、robots.txtテスターについての詳細な解説は、省略させていただきます。詳しい使い方などは、Search Console ヘルプをご覧ください。

⇒Search Console ヘルプ「robots.txt テスターで robots.txt をテストする」

ウェブホスティングサービスを利用していて、robots.txtの編集権限がない場合、ご利用のサービスのヘルプセンターにrobots.txtを編集したい旨を問い合わせてみてください。

おそらくrobots.txtでブロックしているURLがサイトマップに記載されていないでしょうか? サイトマップには、robots.txtでブロックしているURLを記載しないようにしてください。

サイトマップなどでGoogleにインデックス登録を依頼したにもかかわらず、そのURLがrobots.txtによってブロックされ、クローラがクロールできないときに表示されるエラーです。

Search Consoleのカバレッジで「送信されたURLがrobots.txtによってブロックされました」とエラーが表示された場合のエラー内容・原因・解決方法を解説しました。

ほとんどのケースで、サイトマップのURL一覧に記載されているディレクトリまたはページがrobots.txtでブロックされていることが原因かと思われます。

原因は必ずどこかにあるので、Search Consoleでエラーが出てもあわてずにひとつずつ確認し修正しましょう。

ここまで読んでいただきありがとうございました。

この記事をご覧いただいている皆様へ。 このページは、SEO情報ブログ「ディーエムソリューションズの社員が作った、【SEOまとめ】」にて公開さ…

直接的なSEO効果が分からないために、会社情報(組織)のマークアップは後回しにされがちですが、企業情報を正確に伝えるに会社情報(組織)の構造…

この記事をご覧いただいている皆様へ。 このページは、SEO情報ブログ「ディーエムソリューションズの社員が作った、【SEOまとめ】」にて公開さ…

アクセスアップの方法として、多くの企業がSNSを使った情報発信をしているのではないでしょうか?上手に活用できると、情報がシェアされ、ターゲッ…

キーワードの検索結果に表示されるサジェストキーワードは、キーワードを検索するたびにコピペするのは非効率なので、ツールを活用してサジェストキー…

SEOで上位表示をするためにも、おすすめしたいのがGoogleサーチコンソールのサイトマップ送信です。 Googleサーチコンソールにサイト…

今話題のAIによるコンテンツ自動生成機能も!SEO対策に本当に必要な機能だけを搭載した使いやすさとコストパフォーマンスに優れたWeb集客支援ツールです。

Webマーケティングに関わる施策全般をワンストップで

ご提供します。

お気軽にご相談ください。

Webマーケティング最新ニュースのレポートや無料セミナーの先行案内が届く、お得なメルマガ配信中!